截至2021/03/08,谷歌学术上引用林老师Learning PDEs for Image Restoration via Optimal Control的有46篇,打算抽上几篇看看,目前只看了3篇(有笔记的)

ps1:发现林老师此文引用量不高可能是因为没复现代码?

ps2:这次写作的时候发现,如果断网,本地localhost预览博客可能会出现公式无法渲染的问题

Adaptive Partial Differential Equation Learning for Visual Saliency Detection

文献信息

这篇文章是刘日升林宙辰老师的CVPR2014的文章,百度显示至2021/03/09引用量131。标题表明本文提出的模型是自适应学习PDE,模型叫做Linear Elliptic System with Dirichlet boundary (LESD),目标是视觉显著性检测

注1:这个视觉显著性指的是图像中的重要区域,参考这个PPT,比较清楚

注2:显著性后续似乎有别人的很顺眼的工作:参考Salient Objects in Clutter: Bringing Salient Object Detection to the Foreground

注3:读了本文之后觉得它似乎是尝试用传统CV方法解决近年来CV问题。。。好像没用神经网络耶

背景方法与动机

本文的target是显著性检测,分为bottom-up和top-down方法,前者是数据驱动,具体又有纹理特征判断、对比度判断等;后者是模型驱动,直接监督或者通过显著图(map)监督,等

本文的动机:

这个target的问题不简单,要把人的感知(显著区域)和高级(复杂)的先验弄进PDE

林宙辰老师之前ECCV2010的工作有个缺点,对图像的刻画适合传统CV(参考GT的CV课程),对近年来的CV高级任务不合适

ps:读了本文之后觉得它似乎是尝试用传统CV方法解决近年来CV问题。。。

模型LESD与实验

本文提出的模型叫Linear Elliptic System with Dirichlet boundary (LESD),是自适应学习PDE,此PDE的特点是假设了显著性扩散,学习的目标是LESD的公式形式和边界条件。具体扩散的假设是核心!

模拟了人的注意力机制,先注意到图像的一个极其显著的区域,即人注意到的初始区域,记为$\mathcal{S}$,称为显著性种子,然后用PDE模拟注意力转移(扩散)的过程。

下面开始建模,向量或者位置用粗体字母表示。设整个图片区域为$V$,可以由像素点$\mathbf{p}$或者像素块$\mathbf{p}$(超像素)组成;定义实值的注意力score函数,记为$f(\mathbf{p})\overset{def}{=}s_\mathbf{p}$,支集定义在$\mathcal{S}$上。那么在Dirichelet边界条件($V$内$\mathcal{S}$外$f=0$)下,显著性(注意力)扩散的PDE方程为

其中$\mathbf{g}$是$V$之外的点,分数为0。$F$就是一个待定函数

这个score函数$f$对时间的偏导$F$定义为线性扩散项,$div(K_{\mathbf{p}}\nabla f(\mathbf{p}))$,$K_{\mathbf{p}}$是一个非均匀度量张量,用于控制$\mathbf{p}$处的局部扩散率。人的感知怎么导入方程?用正则项,用$\mathbf{p}$的得分和引导图$g(\mathbf{p})$(此$g$是实值函数,非彼$\mathbf{g}$)的差异度量。。。即

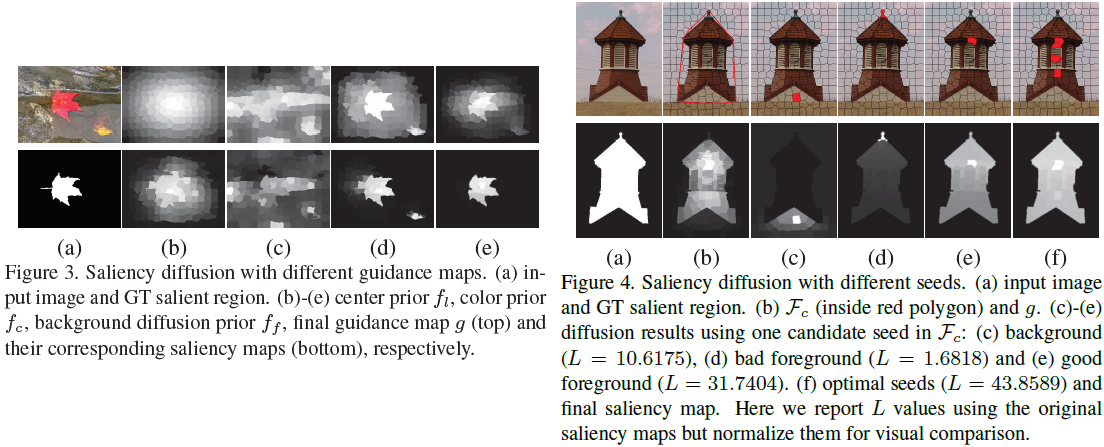

其中度量$K_{\mathbf{p}}$和引导图$g$是干什么的?前者和$f$的形式参考原文$(2.3)$节,后者参考原文$(3.2)$节。。。看的有点累,到处找概念。大概就是本文把图像看成超像素集合,构建了点集意义(即没有概率意义)上的无向图,在注意力区域内$\mathbf{p}$和其多个邻域内的点有连接,连接之间的度量代表扩散的程度,因此$K_{\mathbf{p}}$真的是个度量矩阵,矩阵则有高斯核决定;然后由$K_{\mathbf{p}}$和$g(\mathbf{p})$联合定义了$f(\mathbf{p})$,形式我觉得不重要不写了;最后引导图$g$比较麻烦,本文自己定义出了一个点属于前景的概率$f_f(\mathbf{p})$,乘上本文的参考文献$[34]$中提出的color prior map$f_c$和center prior map$f_l$,最后归一化得到所谓的引导图。我对它的意义不是很理解,只知道是把先验信息弄成像文中图$(3,4)$底部那样的图(取值为$[0,1]$),然后在PDE的约束下去优化得到注意力(显著性)区域

上面所述就是本文的LESD框架,接着假定注意力得分函数随时间不变!为什么?因为我们需要就是给定一张图片后,显著性固定,不随时间$t$变化🆗。由此令$(1)$式中的$F=0$,就是LESD的final形式。现在看这个方程的话,显著性信息就体现在$g$所在区域和$\mathcal{S}$区域的划分上,它们体现了人的感知先验和初始注意力区域的选择

最最后再说一下LESD模型的可行性:文章给出了定理$1$,它保证,在LESD的假设下,score函数$f$是单调次模函数,次模的概念可参考知乎问题,但是具体定义为什么保证可行性我先不管了。。。

实验的话,实验部分不管了,我喜欢的是它展示了一些更改先验感知信息$g$,更改初始区域$\mathcal{S}$的例子,分别见图$(3,4)$。另外展示了实际数据实验的预测准确率等

优缺点

优点

动机不错,考虑更复杂的任务,ECCV2010的PDE形式不太合适了

模型LESD新颖,又是图的建立又是传统CV,还是很interesting的

文章表示LESD的公式中包含了bottom-up和top-down的先验信息。yysy确实既有模型驱动也有数据驱动

文章表示对LESD既有数值,也有理论分析

- 和之前ECCV2010小小对比了下,Discussion部分提了几句,二者target任务不同,本文的任务难一些;二者都是PDE学习,PDE的形式不同;训练的方式不同,10年的是稀疏回归,本文更像是古典CV,从文中算法$1$可以看出来,构造点的连接,然后优化也是离散的,没有涉及网络结构(应该没有)

缺点的话,看不出来啥缺点,可以自圆其说(虽然我不太懂),无情的刷文机器。。

自己的问题(待解决)

文中提了一句PDE处理图像问题的合理性:the multiscale representation of images are indeed solutions of heat equation with different time parameters,我喵喵喵?迷迷糊糊明白一点,但是这个理论需要专门去了解么?

Trainable Nonlinear Reaction Diffusion: A Flexible Framework for Fast and Effective Image Restoration

这文章吓到我了,被干吐了。。

文献信息

本文是16年的TPAMI,一作陈运锦老师,从各方面的资料这个文章还是很猛的

- 文献地址:https://ieeexplore.ieee.org/abstract/document/7527621

- 一作自己的评论:https://www.zhihu.com/question/62599196/answer/233376903

- _JoeZoe关于TNRD模型的博客:https://blog.csdn.net/qq_25196865/article/details/78894051

- 引用了此文的一个专利:一种基于深度学习的自适应图像去噪方法与流程

- 代码实在是找不着,可能在这里。。

- TNRD的一个拓展Image Denoising via Multiscale Nonlinear Diffusion Models,大概就是在下面网络结构图里,第一次卷积前和第二次卷积后分别加一次下、上采样

背景知识

这部分写得细但是乱,不利于展示!

背景是图像恢复/修复问题,图像恢复方法的两个评价对象,修复质量和计算效率。本文在其中的PDE方法上进行改进,下面回顾一下本文主要参考的PDE方法:

刚开始的PM扩散方程

其中$f$是初始待恢复图像,$g$称为边缘停止(edge-stopping)函数或扩散函数,经典的是$\displaystyle g(z)=\dfrac{1}{1+z^2}$。PM扩散方程的特点是非线性各向异性扩散,可以保持和增强图像边缘,我也不知道为什么,但必和这个$div$的形式有关

从PDE的角度去改进,可以改进/选择的有扩散函数、方程的最优停止时间和合适的反作用力(反应扩散方程中的概念),由此,一般的形式如下,即加了正则$\kappa (u)$、系数$a$和各种不变量或者算子$\mathcal{O}(u)$,这个形式和先前林宙辰老师的文章一致:

从传统CV处理图像的方式看,把图像展成列向量$u\in\mathbb{R}^N$,那么

其中$\Lambda(u_t)=diag\left(g\left(\sqrt{(\nabla_xu_t)_p^2+(\nabla_yu_t)_p^2}\right)\right)_{p=1,\cdots,N}$是$N\times N$的对角阵,$g$是扩散函数,$\nabla_x$和$\nabla_y\in \mathbb{R}^{N\times N}$是$x,y$两个方向上的梯度的差分近似,这里算子为$N\times N$维,作用在$u_t\in\mathbb{R}^N$上很奇怪,这一点我没看懂(懂了,见下一段),先跳过。另外定义的$\phi(z)=zg(z)$就是影响函数,也成为flux函数,似乎这个对角阵$\Lambda(u_t)$的元素是和$\nabla u_t$的分量一一对应的,这一点我也没看懂,先跳过

上面是基本的反应扩散方程模型,扩散的过程对应求能量泛函(也可以说是惩罚项)$\displaystyle \mathcal{R}=\sum_{i\in\{x,y\}}\sum_{p=1}^N\rho((k_iu)_p)$的极小,但是为什么是惩罚项是这样的呢?其中函数$\rho$就是惩罚项,如$\rho(z)=\log(1+z^2)$,不知道这里$\rho^\prime (z)=\phi (z)$有没有什么意义。另外注意这里$\nabla_xu$是*矩阵和向量的积,对应线性滤波$k_x=[-1,1]$的作用,确实,从差分的角度看这样是合理的,同理$\nabla_y$对应线性滤波$k_y=[-1,1]^T$的作用

TNRD小结

本文针对图像恢复问题,提出模型TNRD,即标题里的Trainable Nonlinear Reaction Diffusion。它的模型核心/idea是在反应扩散方程中使用了时变的线性滤波器和影响函数(influence function);动机是尽管最近(16年前)的PDE方法在许多图像处理任务中表现出良好的性能,但它们仍然不能为经典的图像恢复任务产生最先进的质量;优化方法是数据驱动,直接最小化损失函数。进行的实验有三个, 高斯图像去噪、单图超分辨、和JPEG deblocking,具体实验很多先不看了

TNRD模型的细节还是比较多的,所以还是决定小结一下

整体的general TNRD模型如博客所述,其实就是:

优化目标中的$u_{gt}$指ground truth图像,$u_{T}$是方程最后一个stage(第$T$个,一共也是$T$个stage)的输出,$s$指有这么多样本,训练集一共$S$张图像,目标也可以使用其它的loss,应该是的🤔;$(5)$式中的条件是general的TNRD,$I_0^s$指第$s$个样本对应的初始带噪图像,是输入的初值

然后要分析最长的那个式子,它也是最复杂的,还是建议参考文章的图$(1)$来理解,如上图。对第$t-1$个stage的第$s$个样本$u_{t-1}^s$的操作如上图蓝色方框所示,对应关系直接给出来,也省得我写一堆字了。其中要注意,网络结构中,第二个卷积(即对应线性滤波)和第一个卷积有关联,注意看第二个卷积头上有一$\bar{}$,表示是把第一个卷积旋转了$180^\circ$!最后最外层的$Prox_{\mathcal{G}}$叫proximal mapping operation,具体公式参考原文图$(1)$下面的公式,它套在最外面是为了让里面的式子可求导,所以用这个所谓的近似映射,怎么近似的就不管啦

最后提一下设置这样形式的反应扩散方程的道理,首先要强调的一点是**这种结构是从传统算法推导出来的**,思路就是从上文的背景模型一步步推出方程,然后里面的反应项(force项)和扩散项就这样设计了。。。我觉得还是从$\nabla u$的离散近似出发,设置成线性滤波的形式,后面的force项则引入影响函数,这样设计出来的,真是的思路还是要参考以前的文献了,此处估计日后不怎么看了作者原话,来自知乎:

这种网络结构是从传统算法推导出来的,不是刻意设计的,然后恰好就和EDSR的residual block的结构相似啦。那是不是意味着EDSR的residual block的结构选择成目前这个样子,效果就好,有一些深层次的原因呢?需要paper的筒子们刻意挖一挖嘛。

另外有个trick是网络中的非线性激活函数由基函数拟合出,文中是63个高斯径向基函数线性组合,这样组合出来的非线性函数的形状可以比较任意,我寻思着这会增加计算复杂度(不像是提前决定好的啊)啊

至于训练方法什么的,再见,叭看!

优缺点

它的优点有:

- 是个灵活的可学习框架,是有线性滤波和影响函数的非线性反应扩散模型

- 调整结构可以适用于多种图像恢复中的任务(如提到的3个实验)

- 模型保持了非线性扩散模型的结构简单性,并且只需要少量的扩散步骤,因此高效

- 似乎是因为结构简单性,可在GPU上高速训练

- 文章表示较好地平衡了计算效率和去噪质量的关系(难道是实验的观察结论)

缺点:

是基于先验知识的分析模型,在获取图像全部特征结构时受到限制,以及在整个训练阶段需要手动的微调参数,此外这些方法训练出的模型都是针对已知具体的噪声级,无法实现未知噪声级图像的盲去噪

这些话是引自一个专利的,参考一种基于深度学习的自适应图像去噪方法与流程

文章自己表示,本文TNRD只适合监督,这似乎不算什么缺点。。

另外我有不少问题,不见得是缺点吧,见上文的彩色字体部分

Toward designing intelligent PDEs for computer vision: An optimal control approach

文献信息

这篇文章是刘日升、林宙辰老师等于11年提交,12年接收,发在Image and Vision Computing这个刊上的

文献地址:https://www.sciencedirect.com/science/article/abs/pii/S0262885612001746

观标题,是用PDE解图像处理问题,这次准备了一个自己去找的框架,不知道是不是又是字典稀疏回归,且待分解~是的,要学习的与时间$t$相关的系数,而且字典大得一批。。

文献小结

这个文章年限摆在那里,方法还是一个以PDE为条件的优化问题。考虑自动从数据中学习限制条件PDE,动机是视觉任务的intuition和手动设计PDE不优美,另外考虑把适合多数视觉任务的不变性当成基本的不变量扔进方程。PDE仍然是要学习不变量的系数,其中最高考虑的是2阶的不变量,这个阶指的是导数的阶,主要包括平移和旋转不变性。优化的目标是正常的loss,输出用ground truth监督

模型细节

这个自动学习PDE的框架有个特点,考虑了两组PDE方程,一个方程用来控制输出图像$u$的变化(evolution)过程;另一个作为所谓的indicator函数$v$,它学习图像的全局特征,辅助监督第一个方程。它的形式如下所示:

如上,直接的观察结论是$u$和$v$的演化都用$F$表示,但是内容可能不同。不过本文中,都还是各种不变量的线性组合

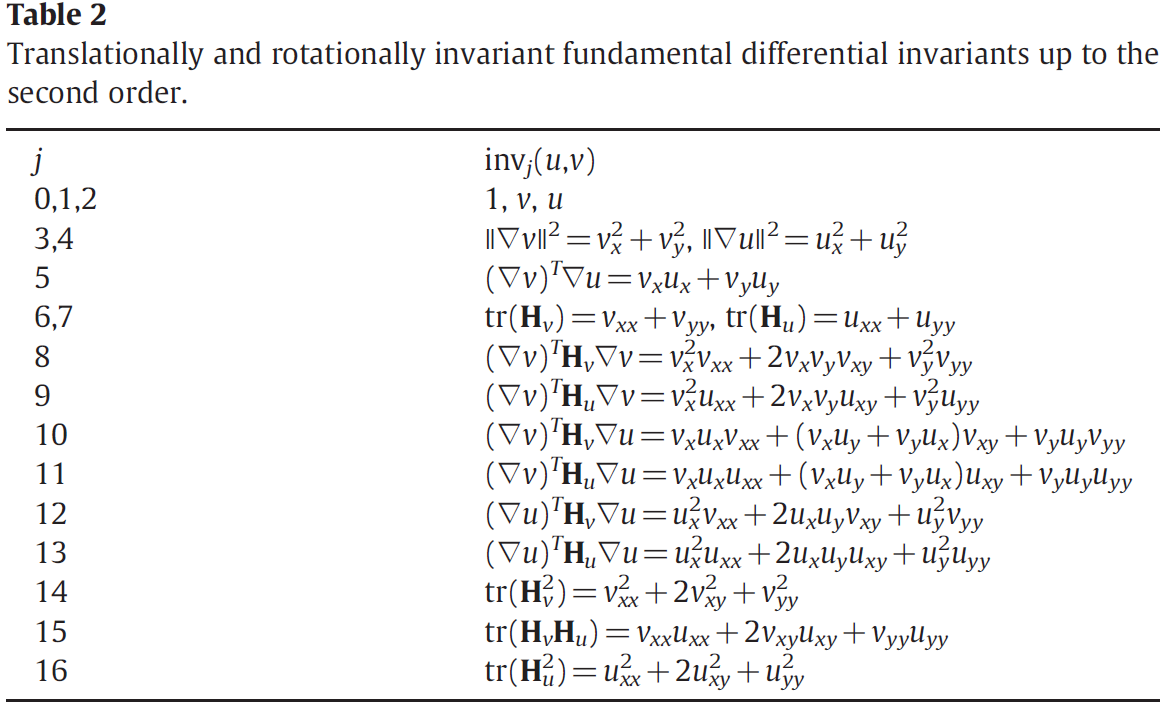

由动机,手动设计PDE,不仅可能只适用少数问题,还很麻烦。因此只说,平移不变性和旋转不变性是大多数vision task的共性,若要保持这些性质,PDE方程的形式需要是平移、旋转这样的算子下不变的(有点像群在集合上作用那味儿),也是这些不变量的函数,依据是文章引用的微分不变量理论。。。

文章声明最高考虑的是2阶的不变量,其理由主要在于更高阶的不变量会有数值问题,以及字典太大导致计算复杂,还有当模型拓展为针对三通道图像时字典更是加大

PDE方程就是这样,没啥。对于优化,优化的目标函数(能量泛函)也很正常,是gt的监督以及两组系数$\mathbf{a,b}$的正则。优化的方法仍然是伴随方法,推导G导数,然后近似迭代

优点

优点:

- 相比原始的10年文章,这个框架引入的不变量更多,还包括一些耦合的不变量,因此框架适用于更多vision task,包括边缘检测、去噪、修复,etc

- 这个证了不变量具有的平移和旋转不变性(没看)

所以说这个文章算是10年那个文章的直接推广,PDE在形式上增广了,加了些不变性理论,加了些实验

最后,注意下几个小知识点:

- 文中提到一个有意思的思路叫Multi-layer PDE systems,每层PDE的形式相同,即最多二阶的不变量的线性组合。但每一层的参数值和初值不同,具体采用贪婪策略学习多层结构,即每一层确定后,用上一层的输出作为下一层的输入。每一层的预期输出都是gt!那么由于每一层都在逼近gt,这样做可能能连续地提高近似的精度

- 突然意识到,这些基于PDE的方法和水平集拓展方法的设计思想没什么区别啊!

其它暂未阅读的文献

- 董彬老师组18年PMLR的Beyond Finite Layer Neural Networks: Bridging Deep Architectures and Numerical Differential Equations

- 剑桥的奇怪杂志Acta Numerica上的Solving inverse problems using data-driven models,不打算看了,174页,像是综述+写书

- 老师一作在CVPR2015上的On Learning Optimized Reaction Diffusion Processes for Effective Image Restoration

- Neural Computing and Applications 2018上的Learning sparse partial differential equations for vector-valued images

- ICASSP 2019上的Learning Compact Partial Differential Equations for Color Images with Efficiency

- 刘日升老师的Valse课件Learning-Based PDE: A New Perspective for PDE Methods in Computer Vision

- 西交孙剑老师的Review,中国工业与应用数学学会,received on 22 April 2020;accepted on 16 June 2020,Model Meets Deep Learning in Image Inverse Problems

参考文献

[1] Risheng Liu, Junjie Cao, Zhouchen Lin, and Shiguang Shan. Adaptive partial differential equation learning for visual saliency detection. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), June 2014.

[2] Y. Chen and T. Pock. Trainable nonlinear reaction diffusion: A flexible framework for fast and effective image restoration. IEEE Transactions on Pattern Analysis and Machine Intelligence, 39(6):1256–1272, 2017.

[3] Risheng Liu, Zhouchen Lin, Wei Zhang, Kewei Tang, and Zhixun Su. Toward designing intelligent pdes for computer vision: An optimal control approach. Image and Vision Computing, 31(1):43–56, 2013.